Sprachassistenz

Wie setze ich eine Schritt-für-Schritt-Anleitung um?

Spracherkennung

Suchbegriffe

Suchbegriffe

Chatbots

Suchbegriffe

Suchbegriffe

Themeneinführung

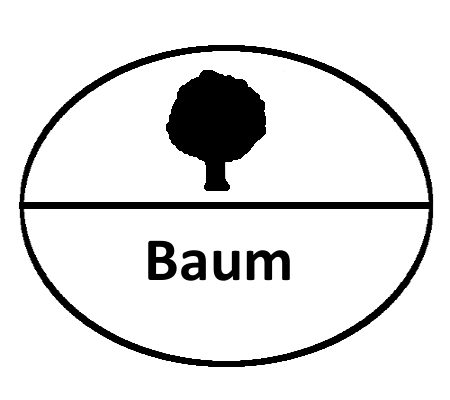

Unter Sprache versteht man im allgemeinen Sinn alle komplexen Systeme der Kommunikation.

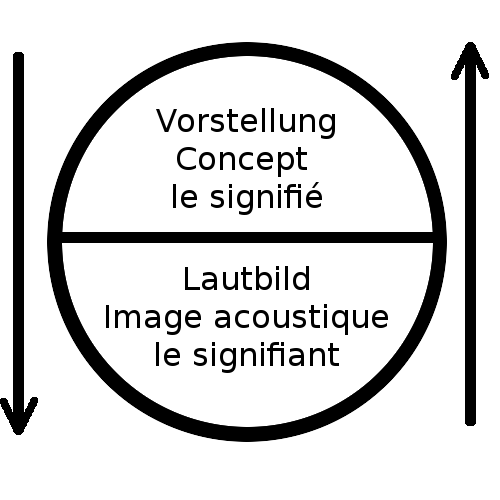

Zentral für die menschlichen Sprachen ist, die willkürliche, nicht zwingende Verbindung von Lautbild und mentaler Vorstellung. (Weiterführend: Wikipedia)

Sprache ist ein System aus Zeichen mit einer Form- und Inhaltsseite.

- Sprache besteht aus einer artikulierenden (z.B. Stimmorgan) und einer aufnehmenden (z.B. Ohr) Seite.

- Sprache besteht besteht aus einer Formalen (z.B. akustisch-vokalen) und einer physiologisch-mentalen (z.B. Gedanke) Einheit

- Sprache hat eine individuelle und eine Soziale Seite. Man kann die eine nicht ohne die andere Begreifen.

- Sprache ist zu jedem Zeitpunkt sowohl ein feststehendes System als auch eine Entwicklung (vgl. de Saussure 2016, S. 8).

Memos zur Vertiefung

Linguistik ist die wissenschaftliche Disziplin, die Sprache beschreiben und erklären soll, z.B.

- Sprache Formal beschreiben - damit z.B. eine Grammatik entwickelt wird, die von Computern lesbar ist.

- Funktionen der Sprache erfassen.

- Historische Stufen der Entwicklung von Sprache Nachzeichnen

- mediale Formen von Sprachen (Laute, Schriftzeichen, Gebärden) aufzeigen

- Beschreibungsebenen (Phonologie, Morphologie, Syntax, Semantik, Pragmatik) benennen

- Sprachliche Variationen (Dialekte, Soziolekte, Jugendsprache, Fachsprache etc.) untersuchen

- Sprache in der Interaktion untersuchen (vgl. Imo und Lanwer 2019, S. 1)

Ein Sprachassistent ist eine Software, die es ermöglicht

- mittels Kommunikation in natürlicher, menschlicher Sprache

- Informationen abzufragen, Dialoge zu führen und Assistenzdienste zu erbringen,

- indem sie zur Spracherkennung eine Sprachanalyse vollzieht, diese semantisch interpretiert, logisch verarbeitet und

- als Ergebnis durch Sprachsynthese eine Antwort formuliert. (Weiterführend: Wikipedia)

Hockett liefert mit den Differenzkriterien menschlicher Sprache und Tierischer Kommunikation sprachtheoretische Grundannahmen (Kontrovers dazu: Everett 2005)

Differenzkriterien zwischen menschlicher Sprache - Tierkommunikation nach Hockett (via Pöhm 2020):

- Vocal-Auditory Channel - Sprechen und Hören: Signale werden durch Schallwellen vom Mund zum Gehör übertragen, nicht visuell, durch Berührung oder auf andere Weise.

- Broadcast transmission and directional reception - Ruf und gerichteter Empfang: Ein Signal lässt sich überall in Hörweite hören, seine Quelle kann durch das Gehör ausfindig gemacht werden.

- Rapid fading - Transistoriness - Vergänglichkeit des Signals: Die akustischen Signale sind äußerst kurzlebig, die spätere Auswertung ist unmöglich (anders bei Tierfährten oder Schrift).

- Interchangeability - Austauschbarkeit: Jeder Sprecher einer Sprache kann eine verstandene sprachliche Mitteilung reproduzieren (im Gegensatz zu den Balzsignalen verschiedener Tierarten, die ausschließlich dem Männchen oder dem Weibchen zur Verfügung stehen).

- Total Feedback - Rückkoppelung: Wer spricht, hört sich selbst zu und kann das Gesprochene bedenken (im Gegensatz zu den bei der Tierbalz häufigen visuellen Signalen, die für das balzende Tier selbst unsichtbar sind).

- Specialization - Spezialisierung: Die Schallwellen gesprochener Sprache haben ausschließlich Signalfunktion (im Gegensatz zum Hecheln eines Hundes, das physiologische Funktion hat).

- Sematnicity - Bedeutungsgehalt: Die Signalelemente tragen Bedeutung durch stabile Bezüge auf die reale Welt (anders als das Hecheln eines Hundes, mit dem dieser nicht »sagt«, dass es ihm heiss ist, sondern das physiologisch zum erhitzten Zustand gehört).

- Arbitariness - Willkürlichkit: Die Signalelemente sind nicht vom Wesen der Realität abhängig, auf die sie sich beziehen (während in den »Bienensprache« die Tanzgeschwindigkeit direkt die Entfernung des Nektars vom Bienenstock wiedergibt).

- Discreteness - Isolierbare Elemente: Die gesprochene Sprache nutzt nur ein begrenztes Sortiment von Lauten, die sich deutlich voneinander unterscheiden (im Gegensatz zu Knurrgeräuschen oder anderen Lauten der Erregung, die in ihrer Intensität kontinuierlich veränderbar sind.

- Displacement- Transfer: Der Mensch kann sich beim Sprechen auf zeitlich oder räumlich distanzierte Dinge beziehen (die meisten Tierschreie sind durch unmittelbare Umweltreize bedingt).

- Productivity - Produktivität: Dem Ausdruck und Verständnis von Bedeutung sind keine Grenzen gesetzt; mit Hilfe aller Satzelemente lassen sich immer wieder neue Sätze bilden (während es bei Tierrufen um feste und begrenzte Abfolgen handelt).

- Traditional Transmission - Überlieferung: Sprache wird von Generation zu Generation vor allem durch Unterricht und Lernen weitergegeben (während die Fähigkeit von Bienen, Nektarquellen anzugeben, genetisch übertragen wird)

- Duality of Patterning - Strukturelle Dualität: Sprachlaute tragen keine eigene Bedeutung, sondern werden auf unterschiedliche Weise zu bedeutungsvermittelnden Elementen (wie Wörtern) kombiniert (anders als Tierrufe, die sich nicht in zwei Strukturebenen unterteilen lassen).

Hockett lässt die Merkmale 6,7, 8 für Primaten gelten, was sicher nur statthaft ist, wenn man Bedeutung und Arbitrarität sehr einfach sieht. Hominoiden schreibt er die Merkmale 11 und 12 noch zu, 10, 11 und 13 sind spezifisch für den Menschen.

Grundprinzipien

- Dauerstreaming: Sämtliche Audiodaten werden permanent übertragen auf zentralen Rechnern (der "Cloud") ausgewertet.

- Keyword: Ein Keyword wird offline erkannt - nach dem Keyword werden bis zu einem festgelegten Endpunkt Audiodaten zur zentralen Auswertung übertragen.

- Online-Training: Sprache wird zum Training online ausgewertet - und dann auf eine offline-Plattform übertragen.

- Offline: Sprache wird ausschliesslich dezentral - auf einer autarken Einheit - erkannt.

Weiterführend: Daten und Datenschutz

Studien

Das Review (2021) schliesst 6 Chatbot-Apps ein:

- CogniCare mobile app (Android/iOS)

- CogniCare (Alexa Skills version)

- My Life Story (Alexa Skills)

- Dementia Types (Alexa Skills)

- Build Your Brain Power (Alexa Skills)

- Everything Memory (Alexa Skills)

Untersucht wird in den Ebenen

-

Effizienz

- Performance

- Wirksamkeit

- Funktionalität

- Menschheit

- Befriedigung

- Einflüsse

- Ethik und Verhalten

Gelöste Fragestellungen

Für einen direkten Vergleich der Sprachassistenten ist es spannend, alle mit dem gleichen Aktivierungswort angesprochen werden. Das ist jedoch nicht möglich:

- Alexa via Web-App: Einstellungen > Geräte [Echo Show] > Allgemein > Aktivierungswort : Auswahl zwischen "Alexa", "Amazon", "Computer", "Echo"

- Google Nest: Hot-Word kann nicht verändert werden (https://tipps.computerbild.de/mobil/smart-devices/...)

- Furhat: Furhat kann mit beliebigen Worten angesprochen werden (https://docs.furhat.io/introduction/#robot-initiat...) Das wirft die Frage auf, welche Daten bei Furhat (und anderen Sprachassistenten) lokal - und welche Daten in der Cloud ausgewertet werden.

Implikationen

- Ein direkter Vergleich der Sprachassistenten im SimDeC - etwa mit dem Aktivierungswort "Spieglein, Spieglein an der Wand" - ist nicht möglich.

- Sprachassistenten mit einem oder wenigen vordefinierten Aktivierungsworten können akustisch ferngesteuert werden, z.B. bei gekipptem Fenster, im Telefonat, via Fernseher.

Methode

Gängige Formen des Genderns werden auf Google-Translate oder acapelabox (max. 300 Zeichen) per Copy& Paste eingefügt und vorgelesen.Versuch 1 - Genderformen, isoliert

- Beid-Nennung: Pflegerinnen und Pfleger.

- Dehumanisierung: Pflegende

- Binnen-I: PflegerInnen.

- Unterstrich: Pfleger_innen.

- Stern: Pfleger*innen.

- Eichhörnchen: Pflegeeichhörnchen.

- Schrägstrich: Pfleger/innen.

- Doppelpunkt: Pfleger:innen.

- Phettberg: das Pflegy und die Pflegys

Versuch 2 - Genderformen, im Satzbau

- Die Pfleger:innen begründen wie folgt: erstens, zweitens, drittens.

- Die Pfleger/innen stehen vor der Wahl: erstens/zweitens/drittens, erstens, zweitens, drittens und ertsens-zweitens-drittens.

- Die Pfleger-innen und die Pfleger/innen fragen sich: /, "/", "-" oder -?

Quellen

- Thomas Kronschläger (2020) Entgendern nach Phettberg

Erstes Szenario kann hier die Kaffee-Zubereitung sein:

- Schritt 1: Anleitungen erstellen

- Schritt 2: Anleitungen überprüfen

- Schritt 3: Anleitungen verbessern

- Schritt 4: Anleitungen als Vorlage für den Sprachassistenten setzen (Einzelne Anleitung umsetzen)

- Schritt 5: Strukturen für das systematische Ergänzen von Anleitungen entwickeln

- Schritt 6: Vorab-Anfrage für Cluster "Möchtest Du Filterkaffe, Espresso oder Cappuchino" setzen

- Schritt 7: Strukturen für das systematische Ergänzen von Strukturen entwickeln

Weiterführende Konzepte

- Die Handlungsanleitung adressiert auf Wunsch verscheidene Medien (Text, Sprache, Bild, Video)

- Die Handlungsanleitung adressiert verschiedene Ausführlichkeit

- Welcher Schritt kommt als nächstes?

- Welche Parameter (Kaffeemenge, Zeit, etc.) sind für einen Schritt wichtig?

- Wie genau wird ein Schritt ausgeführt?

- Die Handlungsanleitung adressiert verschiedene Kompetenzstufen

- Anfänger: Lineare Schritt-Für-Schritt-Anleitung

- Fortgeschrittene: Tipps und Anregungen zu Variationen

- Experte: Die Handlungsanleitung dokumentiert neue Variationen

- Die Handlungsanleitung evaluiert das Ergebnis, z.B. via Aroma-Rad.

- Die Handlungsanleitung gibt Tipps (z.B. Warum habe ich zu wenig Crema? Wie gelingt der Milchschaum)?

- Die Handlungsanleitung löst Probleme (z.B. eine Lampe blinkt, Wassertank ist leer, ich bekomme keine Crema)

- Die Assistenz erinnert an die Einnahme der Medikation zum richtigen Zeitpunkt.

- Assistenz stellt sicher, dass er die richtige Person anspricht

- Die Assistenzstellt sicher, dass die richtigen Arzneimittel vorliegen

- Die Assistenzstellt sicher, dass sie in der richtigen Dosis vorliegen

- Die Assistenzstellt sicher, dass sie in der richtigen Applikationsart vorliegen.

- Die Assistenzdokumentiert die Einnahme der Arznei.

- Die Assistenz gibt (nach Aufforderung, nach Wechsel einer Arznei, Aufdosierung, Ausschleichen Hinweise), z.B. zu

- Veränderungen

- Unerwünschter Wirkung

- Wechselwirkung

- Die Assistenz nimmt Fragen zum Medikament entgegen und gleicht diese mit Datenbanken ab.

- Die Assistenz stellt Bezüge zwischen Symptomen und möglichen Wechsel- und Nebenwirkungen der Arzneien her.

- Die Assistenz zeigt Bilder der Einzunehmenden Medikamente.

- Die Assistenz scannt den QR-Code bzw. BarCode auf der Verpackung und gibt Information zu den Medikamenten.

- Die Assistenz begleitet beim richten von Tropfen

- Die Sprachassistenz passt Lesegeschwindigkeit und Betonung den Bedürfnissen der Person an.

- Die Sprachassistenz wechselt die Stimme entsprechend der Charaktere (z.B. in Theaterstücken)

- Skills: Auf Furhat Robtoics Furhat sind "Skills" das, was bei Google Nest als "Actions" bezeichnet wird - eigene Programme.

- Developer Zone

- Furhat Skills Tutorials

- Example Skills

Zum Programmieren eines ersten Skills empfehlen wir Blockly

- Skills: Auf Amazon Alexa sind "Skills" das, was bei Google Nest als "Actions" bezeichnet wird - eigene Programme.

- Alexa Skills Kit

- Alexa Skills Tutorial

- Tutorial

- Actions: Auf dem Google Nest sind "Actions" das, was bei Amazon Alexa als "Skill" bezeichnet wird - eigene Programme.

- Google Assistant SDK

- Google Actions Builder

- Welche Risiken in Bezug auf Datenschutz und die informationelle Selbstbestimmung müssen bewertet werden?

- Welche Risiken in Bezug auf Finanzen gibt es (Einkäufe auslösen, Trickbetrug, ...)

- Welche Risiken in Bezug auf Sensorik gibt es?

- Welche Risiken in Bezug auf Aktorik gibt es? (Einbindung von Motorschloss, Schaltaktoren etc.)

Informationelle Selbstbestimmung

- In welchen Fällen wird Ton lokal verarbeitet, in welchen Fällen in der Cloud (auf wessen Servern?)

- Werden Key-Words analysiert?

- Wird die Semantik analysiert?

- Wird die Tonlage/Emotion analyisiert?

- Analysieren auch Menschen?

- Sind Kameras verbaut? In welchen Fällen wird visuelle Information (Helligkeit, Bilder, Videos) lokal oder in der Cloud verarbeitet?

- Werden Gesten analysiert?

- Wird Mimik analysiert?

- Wird Anwesenheit analysiert?

- Analysieren auch Menschen?

- Welche weiteren Sensoren sind beteiligt?

- Schalter/Buttons

- Touch-Displays

- Helligkeit

- Kaffeezubereitung mit den einzelnen Kaffeemaschinen

- Was ist zu tun, wenn ich das SimDeC betrete?

- Was ist zu tun, wenn ich das SimDeC verlasse?

- Fragen und Informationen zu den Artefakten im SimDeC abrufen (Webcams, Kamerasysteme, ...)

- Anleitung zum Umgang mit Alarmen

- Fragen zur Automatisierung (Lichtsteuerung, Assistenzsysteme)

- Sprachansagen

- Illustration mit Texten

- Illustration mit Bildern

- Illustration mit Videos

- Kochrezept-Anleitungen, Cookbooks

- Datenbank-Abfragen

- Welche Sensoren können ausgelesen werden?

- Welche Sensoren sollen im SimDeC ausgelesen werden?

- Welche Aktoren können angesprochen werden?

- z.B. Ikea/Hue und Amazon Alexa?

- Welche Aktoren sollen im SimDeC angesprochen werden?

- Im Bereich Dementia Care

- Im Bereich der (häuslichen) Pflege

- Im Bereich der Betreuung